In DNN plaats het robots.txt bestand in de root van de website. In de robots.txt geef je de user-agent en de te indexeren pagina’s aan. Het is een cruciaal onderdeel van SEO.

Wat is een robots.txt?

Het robots.txt bestand geeft webmasters de mogelijkheid om zoekmachines te instrueren welke pagina’s zij wel en niet mogen indexeren. Dit is een "gewoon" text-bestand dat werkt op basis van het Robots Exclusion Protocol. Dit protocol stelt webmasters in staat bepaalde pagina's uit te sluiten van indexering in specifieke zoekmachines. De syntax die gebruikt dient te worden in robots.txt:

User Agent: [naam specifieke spider]

Disallow: [paginanaam]

Het robots.txt bestand van een website is normaliter te vinden op:

Wat is de invloed van robots.txt op zoekresultaten?

Voordat je het robots.txt bestand instelt, moet je eerst weten wat zoekmachines nodig hebben om jou website zo goed mogelijk te indexeren. Het wijzigen of instellen van het robots.txt bestand beïnvloedt namelijk de vindbaarheid in zoekmachines.

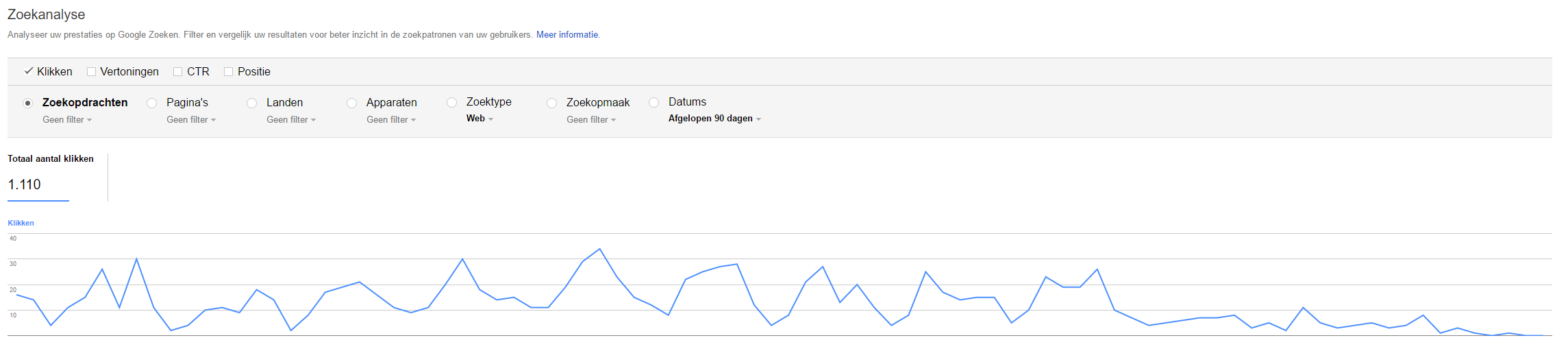

Blokker nooit JavaScript of CSS via het robots.txt bestand. Waarom? Omdat zoekmachines het Document Object Model (DOM) interpreteren. Dus als toch een JS of CSS bestand blokkeert kan Google niet zien of je witte teksten op een witte achtergrond heb gezet. Het DOM interpreteren biedt zoekmachines de mogelijkheid om black hat seo technieken af te straffen. Wanneer je in Google Search Console dus een daling ziet van het aantal weergaven, controleer dan eerst altijd het robots.txt bestand en de indexeringsstatus van je website.

Zelf maakt Google de aanbeveling om de Googlebot nooit te blokkeren. Bij een verslechtering van de vindbaarheid in de zoekresultaten biedt Google een stappenplan aan webmasters.

Wat kunnen zoekmachines indexeren?

Een veel voorkomende uitspraak is dat Google geen JavaScript kan indexeren, niets is echter minder waar. Uit onderzoek van Searchengineland blijkt namelijk dat de bots van Google slim genoeg zijn om dynamische websites perfect te indexeren.

Google heeft een lijst gepubliceerd met alle bestandtypen die het kan indexeren. Dat Google al deze bestanden kan indexeren wilt niet zeggen dat je ze ook moet gebruiken. Onder meer Flash wordt afgeraden om te gebruiken. Google heeft namelijk nog steeds moeite om Rich Media te indexeren. Geef bij dergelijke bestanden dan ook altijd een goede alt tekst en title.

Spiders en crawling van robots.txt

In principe indexeren en tonen zoekmachines elke webpagina die zij kunnen vinden. Elke zoekmachine maakt daarbij gebruik van zijn eigen crawler. Alle crawlers zijn in te zien in de robots database. Gelukkig kan je met een aterisk (*) al deze spiders in één keer instrueren.

Toestaan dat alle pagina’s worden geïndexeerd:

User-agent: *

Disallow:

Of:

User-agent: *

Allow: /

Uitsluiten dat de website wordt geïndexeerd:

User-agent: *

Disallow: /

Uitsluiten van de Admin & search omgeving in DNN:

User-agent: *

Disallow: /Admin

Disallow: /Default.aspx?*

Disallow: /?Search=

Voor het instellen van de robots.txt per spider, stel je naast generieke uitsluitingen ook uitsluitingen per spider in:

/*User Agent Google*/

User-agent: Googlebot

Disallow: /App_Browsers/

/*User Agent Yahoo*/

User-agent: Yahoo Pipes 1.0

Disallow: /Resources/

/*User Agent Bing*/

User-agent: msnbot

Disallow: /Resources/

/*User Agent Twitter*/

User-agent: Twitterbot

Disallow: /Resources/

Een goed robots.txt bestand

Afhankelijk van de opbouw van je DNN website stel je de robots.txt in. Voor een DNN website geldt dat de Adminomgeving moet worden geblokkeerd. Een goed robots.txt bestand bevat naast blokkeringen ook een verwijzing naar de XML sitemap.

Sitemap: http://dotnetnuke.nl/sitemap.aspx

Robots.txt vs meta robots

Op rootniveau stel je het robots.txt bestand in. Op paginaniveau kan je de spiders extra informatie meegeven aan de hand van meta tags. Het robots.txt bestand instrueert zoekmachines of ze überhaupt een pagina mogen indexeren, de meta tag instrueert zoekmachines op welke wijze die pagina moet worden geïndexeerd. Een typische robots meta tag:

<meta name="googlebot" content="noindex" />

Voor de metatag bestaan verschillende instructies.

| Instructie |

Beschrijving |

| All |

Er gelden geen beperkingen voor het indexeren of de weergave. Opmerking: Deze instructie is de standaardwaarde en heeft geen effect als deze expliciet wordt vermeld. |

| noindex |

Deze pagina niet weergeven in zoekresultaten en geen link 'In het cachegeheugen opgeslagen' weergeven in zoekresultaten. |

| nofollow |

De links op deze pagina niet volgen. |

| none |

Gelijk aan noindex, nofollow. |

| noarchive |

Geen link 'In het cachegeheugen opgeslagen' weergeven in zoekresultaten. |

| nosnippet |

Geen fragment in de zoekresultaten weergeven voor deze pagina. |

| noodp |

Geen metadata uit het Open Directory-project voor titels of fragmenten weergeven voor deze pagina. Deze data is te vinden op DMOZ. |

| notranslate |

Geen vertaling voor deze pagina aanbieden in zoekresultaten. |

| noimageindex |

De afbeeldingen op deze pagina niet indexeren. |

| unavailable_after: [RFC-850 date/time] |

Deze pagina niet na de opgegeven datum/tijd weergeven in zoekresultaten. De datum/tijd moet worden opgegeven in RFC 850-indeling. |

Voor een complete uitleg verwijs ik je naar Google.

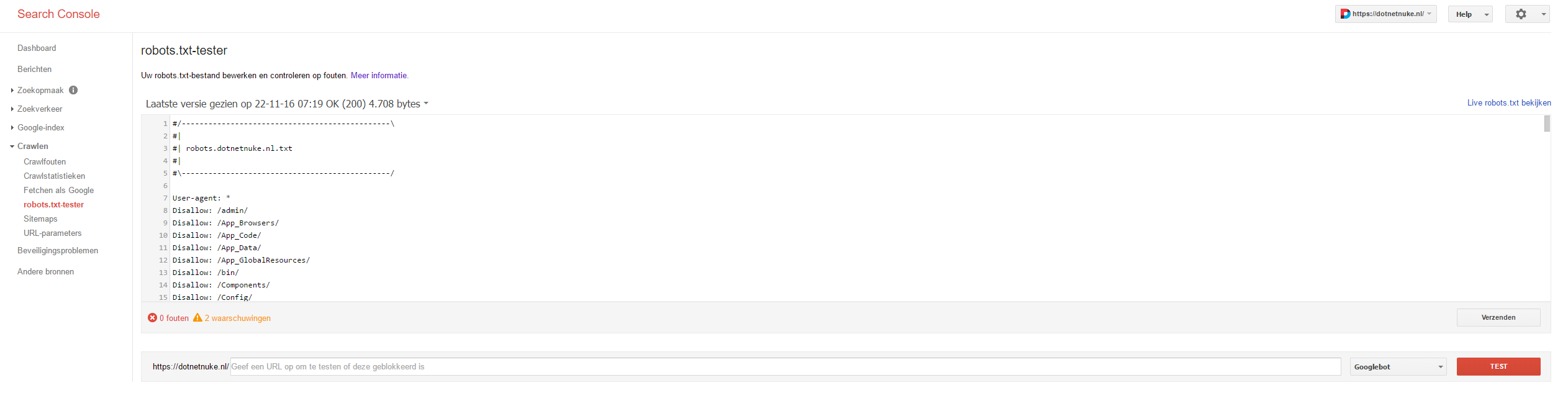

Robots.txt testen en verzenden naar Google

Als je het robots.txt bestand hebt geplaatst in de www directory van je website kan je hem naar Google verzenden. Dit wordt gedaan via Search Console.

In de balk geef je de url op waar de robots.txt is te vinden om vervolgens aan te geven welke bot de pagina moet indexeren.